AI Tinkerers: il mio primo meetup a Medellín

Ho partecipato per la prima volta a un meetup del gruppo AI Tinkerers, ospitato negli spazi di Nodo presso l’universidad EAFIT di Medellín. Nodo è il centro di formazione e sperimentazione tecnologica dell’ateneo, nato per sviluppare skills pratiche su AI, data science e sviluppo software, grazie a partnership con aziende e istituzioni pubbliche. È un ambiente che punta a risolvere problemi concreti, favorendo l’incontro tra la comunità di professionisti e la ricerca accademica, con un approccio orientato ai risultati.

Nodo, inaugurato a luglio del 2022, propone hackathon, workshop e percorsi formativi brevi, aggiornabili ogni mese e liberi dalla rigidità accademica tradizionale. Tra le iniziative ospitate spiccano anche gli eventi della vivace comunità AI Tinkerers, formalmente costituita ad aprile 2024 con “Lanzamiento de AI Tinkeres Medellìn”, che ha già iniziato a riunirsi con regolarità per esplorare e sperimentare insieme le tecnologie di AI ("AI Tinkerers: una nuova ondata di makers a Medellìn", 2024).

Un pomeriggio tra campus e innovazione

Era la prima volta che partecipavo a un evento del genere e, arrivato con un certo anticipo nel pomeriggio — verso le 16:00 — ho approfittato per fermarmi al centro commerciale Oviedo, vicino all’università, dove mi sono concesso un palito de queso. Assieme a questo spuntino stavo leggendo "Geopolitica dell’intelligenza artificiale" di Alessandro Aresu, un saggio che analizza come l’AI stia ridefinendo gli equilibri politici, economici e strategici globali, con particolare attenzione alle sfide di governance e al ruolo delle grandi potenze.

Dopo questa pausa, prima di trovare la sede dell’evento al Bloque 18 (Piso 2), ho fatto un giro per il campus universitario, approfittando del tempo a disposizione per esplorare gli spazi e respirare l’atmosfera accademica. L’inizio ufficiale dell’incontro era previsto per le 18:00.

Talk Time: spunti e idee dal meetup

Il programma prevedeva tre talk, ma solo due erano quelli che mi interessavano maggiormente per la loro attinenza con il mio lavoro. All’inizio si sono verificati alcuni problemi tecnici: lo schermo non funzionava correttamente, costringendo relatori e partecipanti ad attendere qualche minuto per sistemare la connessione video. Una volta risolto il guasto, i talk hanno potuto partire regolarmente.

Il primo talk si è concentrato sulla costruzione di sistemi meta-agentici, ovvero architetture in cui un “meta-agente” è in grado di generare il prompt per coordinare ed esaminare altri agenti più piccoli. Infine attraverso simulazioni e metriche di valutazione, come Ragas, questi sistemi permettono di testare le prestazioni degli agenti in scenari realistici, riducendo la possibilità di generare allucinazioni e aumentando la robustezza complessiva delle risposte.

Il secondo talk ha presentato invece un’architettura agentica applicata alle reti Wi-Fi. Partendo da un Small Language Models (sLM) come Mistral 7B, si è costruito un agente specializzato nel fornire risposte tecniche affidabili, con bassa latenza e senza dipendere da modelli di grandi dimensioni in cloud.

Questa soluzione sfrutta la cosiddetta agent distillation, cioè il trasferimento di conoscenze da un large language model (LLM) come Gemini 2.5 verso un modello più piccolo e leggero (sLM) e ottimizzato per funzionare on-premise. Inoltre, è stato adottato un approccio di ragionamento step by step (Chain of Thought), validato sia da esperti di dominio umani sia da strumenti automatici come RagaAI.

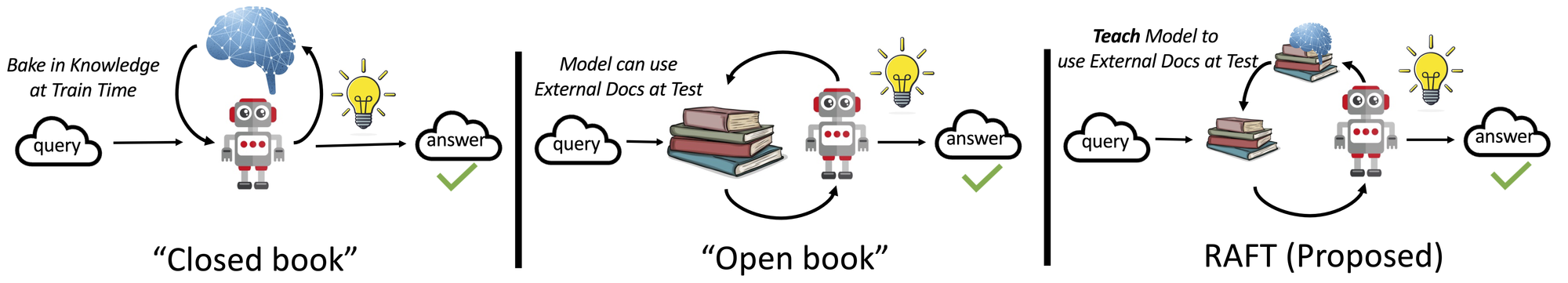

Una parte particolarmente interessante di questa presentazione è stata la spiegazione di RAFT (Retrieval-Augmented Fine-Tuning), una tecnica che integra direttamente la fase di recupero delle informazioni (retrieval) all’interno del processo di addestramento del modello.

Diversamente del classico approccio RAG, dove retrieval e generation restano separati, RAFT unifica le fasi in un unico processo, semplificando la pipeline e rendendo le risposte più stabili e consistenti. Questo approccio allena il modello non solo a usare documenti rilevanti, ma anche a ignorare quelli inutili, riducendo errori da embedding scadenti o chunking poco preciso. Inoltre, RAFT introduce marcatori specifici (ad esempio ##begin_quote## e ##end_quote##) per evidenziare in modo trasparente i passaggi copiati dai documenti, aiutando il modello a citare con precisione le fonti e a ridurre ulteriormente le allucinazioni. In pratica, è come preparare un LLM a un “esame a libro aperto”, ma limitato a un dominio specifico, così da sfruttare al meglio le fonti pertinenti.

Durante il talk è stato mostrato l’intero workflow: dall’addestramento iniziale, al deployment su vLLM, fino all’integrazione via API e a casi reali di domande tecniche gestite dall’agente. Proprio vLLM, grazie alla sua gestione efficiente della memoria e al parallelismo, ha permesso di ridurre drasticamente i tempi di latenza e i costi, migliorando la scalabilità in scenari produttivi.

What I took away

Questo primo meetup di AI Tinkerers a Nodo EAFIT mi ha lasciato la consapevolezza che la community AI, anche qui a Medellín, sta affrontando sfide molto simili a quelle che ho visto in Europa: portare i modelli in produzione, garantire coerenza e ridurre i costi.

Ho trovato particolarmente stimolante vedere come approcci come i meta-agenti, la distillazione agentica e tecniche come RAFT possano migliorare la stabilità e l’affidabilità dei modelli, avvicinandoli alle esigenze reali delle aziende.

Sitografia

[0] Primer año de Nodo, un centro con conexión ganadora para los graduados de la U, 15/04/2025

Papers

[0] Cedric Vidal, RAFT: A new way to teach LLMs to be better at RAG, Microsoft Tech Blog, 15/03/2024

[1] Tianjun Zhang, et al., RAFT: Adapting Language Model to Domain Specific RAG, 05/06/2024

[2] Minki Kang, et al., Distilling LLM Agent into Small Models with Retrieval and Code Tools, 23/05/2025