If You Can Imagine It, AI Can 3D Print It

Immagina di partire da una semplice fotografia — il volto di un personaggio, un oggetto qualunque sulla scrivania — e trasformarla in un modello 3D pronto per essere modificato, stampato, usato. Fino a pochi mesi fa sarebbe sembrato sci-fi; oggi è una possibilità reale.

L’AI applicata al 3D evolve rapidamente, ma soffre ancora di problemi di stabilità e prevedibilità.

Creativity

Negli anni ’70 l’ambiente dell’Università dello Utah — in particolare il dipartimento di informatica — era animato da figure leggendarie come Ivan Sutherland e Dave Evans, capaci di attirare alcuni dei migliori studenti dell’epoca offrendo loro spazio, accesso ai computer e, soprattutto, la libertà di seguire i propri interessi di ricerca.

Come racconta Ed Catmull in Creativity, Inc., quell’ambiente era frequentato da persone destinate a rivoluzionare il mondo della tecnologia: Jim Clark (fondatore di Silicon Graphics e Netscape), John Warnock (cofondatore di Adobe) e Alan Kay (pioniere delle GUI, della OOP), solo per citarne alcuni. Non è un caso che Catmull abbia poi cercato di ricreare quello stesso spirito di apertura e sperimentazione all’interno della Pixar.

In questo contesto, nel 1975, Martin Edward Newell, allora dottorando in computer science, modellò la geometria di una teiera a partire dalle misure manuali di un oggetto reale, con l’obiettivo di testare algoritmi di rendering e shading.

Il modello, composto da 28 superfici di Bézier cubiche, è considerato uno dei primi esempi nella computer graphics di oggetti definiti tramite superfici non lineari continue, anziché come mesh poligonali.

Nel corso degli anni la Utah Teapot è diventata così iconica da uscire dal contesto accademico e approdare nella cultura pop. Nel primo Toy Story della Pixar, uscito nel 1995, durante la celebre scena del tea party in cui Buzz Lightyear e gli altri giocattoli sono seduti attorno al tavolo, compare una teiera che riproduce direttamente il modello di Newell.

Image-to-3D

L’image-to-3D procede in direzione opposta. Parte da immagini bidimensionali, dove la geometria non è data, ma deve essere ricostruita per inferenza. Un'ombra può indicare tanto una cavità quanto una sporgenza, una curva può mascherare uno spigolo, una singola vista può corrispondere a infinite forme tridimensionali distinte.

La ricostruzione di modelli tridimensionali da immagini 2D è oggetto di ricerca da decenni: dalla fotogrammetria classica alle tecniche di computer vision, fino alle reti neurali addestrate a inferire profondità, superfici e volumi assenti. Il principio appare elementare: risalire da una o più proiezioni 2D a una forma 3D coerente.

Il limite intrinseco, tuttavia, resta invariato: l'ambiguità geometrica. Una singola immagine contiene infinite possibili interpretazioni tridimensionali.

Come ridurre questa incertezza? Non chiedendo a un’AI di "generare un modello 3D" da una sola immagine, ma fornendo le viste multiple e coerenti dello stesso oggetto: fronte, retro, lati, dall’alto. In questo scenario l'AI abbandona la generazione speculativa per passare alla ricostruzione vincolata. A partire da queste proiezioni controllate, un secondo tool — ad esempio Hitem 3D, Rodin, Hunyuan 3D , Tripo3D , Trellis.2— può generare una mesh solida, sorprendentemente fedele e spesso già pronta per la stampa 3D.

Ed è proprio in questo step del workflow che interviene Nano Banana🍌.

Nano Banana🍌non è un tool 3D — ed è proprio questo il punto

Nano Banana è attualmente uno dei generatori di immagini più popolari di Google. Nasce per creare immagini, non mesh. Non esporta STL, non conosce poligoni, non ragiona in termini di manifold o spessori di parete. Eppure, se integrato nel workflow appropriato, si rivela uno strumento notevolmente efficace per la stampa 3D.

La ragione è che Nano Banana🍌 risolve un problema centrale dell'image-to-3D: la persistenza dell'identità visiva attraverso viste multiple. Mantiene intatte le caratteristiche di un oggetto o personaggio su proiezioni differenti e modifiche successive, preservando proporzioni, dettagli o stile.

Progettare prima l’immagine, poi il modello

L’idea è semplice: prima si progetta l’oggetto in 2D, poi lo si trasforma in un modello 3D.

Possiamo iniziare chiedendo a Nano Banana🍌 di generare l’immagine di Gizmo, protagonista di uno dei miei film preferiti, Gremlins. Un dettaglio non secondario: Gremlins è, a tutti gli effetti, un film natalizio. L’intera storia è immersa nell’estetica del Natale — luci, neve, decorazioni — ed è quindi un soggetto ideale per testare modifiche contestuali senza perdere coerenza visiva.

Il risultato iniziale è già più che convincente, ma per lavorare in ottica 3D serve un background pulito. Il prompt viene quindi affinato: si semplifica lo sfondo, si eliminano elementi superflui, si rifiniscono i dettagli.

Il risultato è già più che convincente, ma per il 3D serve un background bianco o nero. Infine si affina il prompt, si semplifica lo sfondo, si rifiniscono i dettagli.

python main.py "Create a realistic, detailed miniature of original Gremnlins Gizmo. Give it a plain, simple black background"A questo punto l’immagine potrebbe già essere considerata quella "finale". Ma la vera forza del processo emerge quando si inizia a intervenire in modo iterativo, modificando ogni dettaglio attraverso il linguaggio naturale. È sufficiente descrivere ciò che si desidera e Gemini 2.5 Flash Image si occupa di aggiornare i dettagli visivi.

Proprio perché il contesto è natalizio, decidiamo di aggiungere un cappello di Natale. Poco dopo cambiamo idea: vogliamo che Gizmo tenga in mano un candy cane, ma senza il cappello. Tutto il resto deve rimanere identico — posa, proporzioni, stile.

Con una classica AI di modellazione 3D, una richiesta del genere avrebbe con tutta probabilità compromesso la coerenza del modello. Qui accade l’opposto: Nano Banana🍌 mantiene il contesto e applica la modifica con una precisione quasi chirurgica.

La svolta: multi-view

Quando decidiamo che il design è pronto, arriva il passaggio chiave. Si chiede a Nano Banana🍌 di generare la stessa identica miniatura, ma vista:

- Front (vista frontale, angolazione frontale, inquadratura frontale)

- Back (vista posteriore, angolazione retro, inquadratura posteriore)

- Left (vista laterale sinistra, angolazione laterale sinistra, profilo sinistro)

- Right (vista laterale destra, angolazione laterale destra, profilo destro)

- Top (vista dall'alto, angolazione top view, vista aerea, vista dall'alto)

Se qualche dettaglio viene perso, basta segnalarlo: l’AI lo corregge in pochi secondi.

Nel giro di cinque minuti ci si ritrova con un set completo di viste coerenti, tutte riferite allo stesso oggetto che prima non esisteva.

Dalle immagini alla mesh

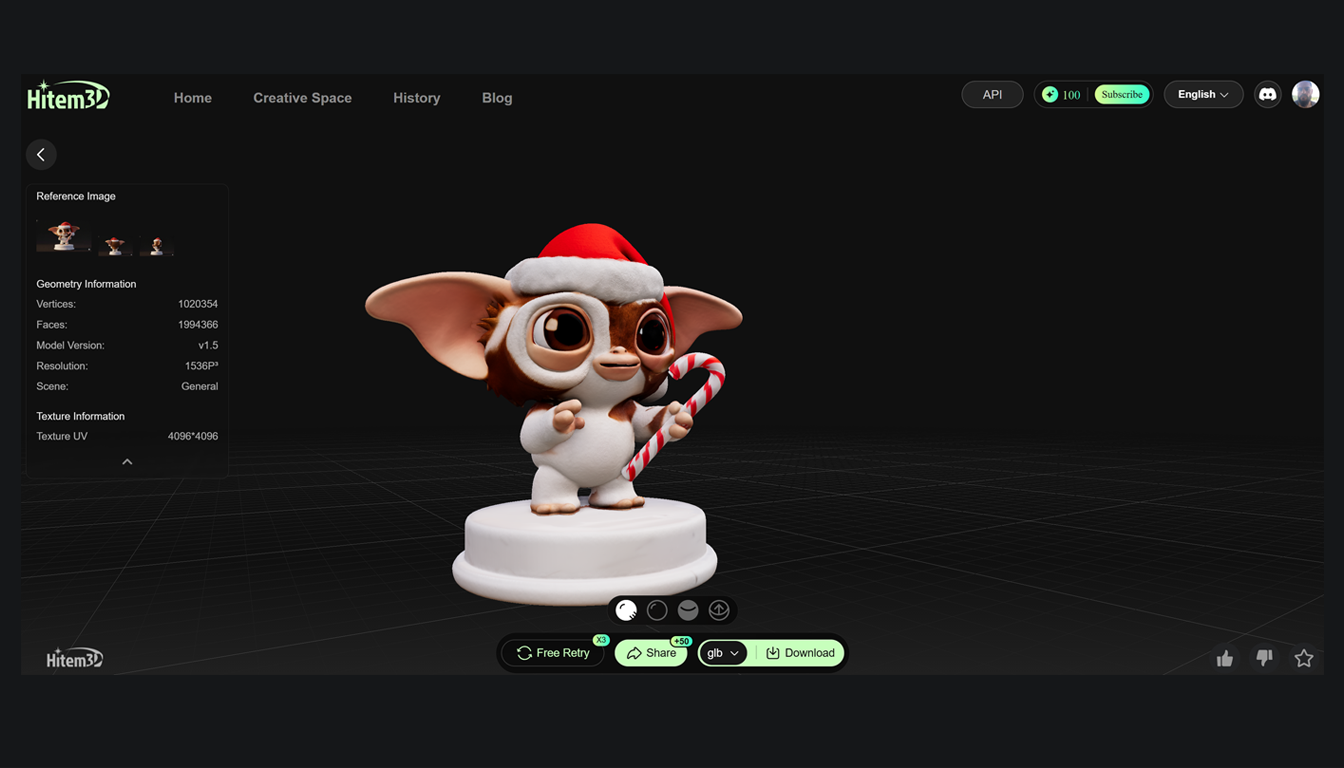

A questo punto entra in scena qualsiasi tool di image-to-3D che supporti viste multiple. Ne esistono diversi online; Hitem 3D è tra i più utilizzati, ma il principio rimane indipendente dalla piattaforma specifica. Ciò che conta non è tanto il servizio in sé, quanto l’approccio: ricostruire una geometria tridimensionale coerente a partire da più proiezioni bidimensionali dello stesso oggetto.

Si caricano le immagini, l’AI analizza le proiezioni e ricostruisce una mesh tridimensionale completa. Il risultato è un modello pronto per essere stampato, senza dover scolpire nulla a mano e senza passare ore in Blender o ZBrush.

Hitem 3D

Hitem 3D è un’AI pensata specificamente per trasformare immagini 2D in modelli 3D, con un’attenzione particolare alla stampa 3D. Inizialmente il progetto aveva guadagnato popolarità perché nato come iniziativa open-source con il nome di Sparc3D; tuttavia, nel maggio del 2025, il suo passaggio a una piattaforma a pagamento, Hitem3D, ha acceso forti polemiche all’interno delle community di sviluppatori e makers.

La piattaforma consente di generare modelli partendo da una singola immagine, da ritratti oppure da più viste (front, back, lef, right) tramite la modalità Multiview to 3D, che migliora sensibilmente la qualità e la coerenza del risultato finale.

Uno dei punti di forza dichiarati di Hitem 3D è l’elevata risoluzione delle mesh, che può arrivare fino a 1536 voxel. I voxel sono l’equivalente tridimensionale dei pixel e rappresentano unità volumetriche discrete che descrivono la forma nello spazio: più alta è la risoluzione voxel, più fine è la capacità del modello di catturare curvature, spigoli e dettagli complessi.

Nei test, le mesh risultano ben chiuse (watertight), senza normali invertite o superfici difettose, e quindi direttamente stampabili senza steps intermedi di riparazione o correzione manuale. Questo rende Hitem 3D particolarmente adatto a un workflow rapido e lineare:

- si caricano le immagini

- si genera il modello

- si porta il modello allo slicer

Acceleratore creativo per makers e designers

Nel complesso, Hitem 3D si presenta come un tool solido per la generazione rapida di modelli 3D, ideale come punto di partenza per designer e maker. Più che una soluzione definitiva, va inteso come un acceleratore creativo, adatto al prototyping, ma non ancora pensato per modelli accurati o per una gestione multi-color per la stampa 3D.

Dal punto di vista pratico, Hitem 3D offre un’interfaccia semplice, tempi di generazione accettabili (alcuni minuti per i modelli più complessi) e diversi formati di esportazione, tra cui STL per la stampa 3D, OBJ, FBX e GLB.

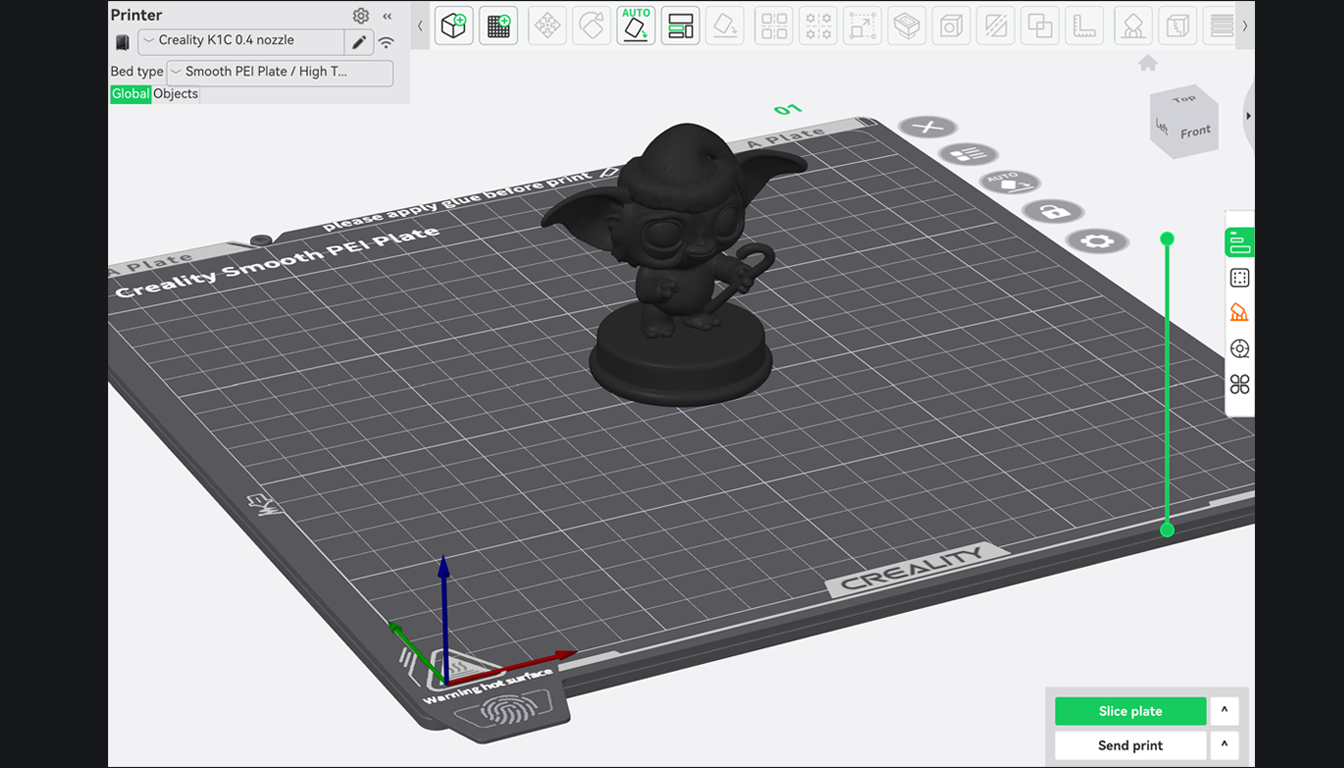

Nel mio caso ho stampato più di un modello generato con Hitem 3D utilizzando una Creality K1C e lo slicer Creality Print, ottenendo ottimi risultati, con interventi di pulizia e rifinitura minimi.

La cosa sorprendente è la qualità finale: anche stampando con una stampante FDM, i dettagli rimangono definiti.

Perché questo workflow funziona così bene?

Generare un modello 3D partendo da una singola immagine è sempre stato un azzardo. Le parti non visibili costringono l’AI a "inventare", e l’invenzione raramente coincide con ciò che avevamo in mente.

La differenza, qui, è il controllo.

Nano Banana🍌 è il primo tool che permette di creare viste multi-planari accurate di oggetti immaginari, mantenendo coerenza geometrica tra un’inquadratura e l’altra.

Dopo aver testato decine di AI per il 3D modeling, questo risulta — almeno oggi — il workflow più affidabile per chi vuole stampare in 3D senza rinunciare al controllo creativo.

Non è magia.

È semplicemente la combinazione giusta di tools, usati nel modo giusto.

E, onestamente, è una di quelle cose che ti fanno venir voglia di guardare la stampante 3D e pensare:

If You Can Imagine It, AI Can 3D Print It

📚Bibliografia

[0] Ed Catmull, Creatividad, S. A. Cómo Llevar la Inspiración Hasta el Infinito y más Allá (Nueva Edición), Conecta, 2024

🔗Sitografia

[0] David C. Brock, Behold, the World’s Most Famous Teapot, IEEE Spectrum, 27/10/2017

[1] Alexey Yurasov, 3D modeling with Python, Medium, 07/05/2022

[2] Vset3D, The Sparc3D Controversy : From Open-Source Promise to Paid Hitem3D Platform, VSET3D, 17/09/2025

[3] James Skeleton, Create 3D assets from Images with GPU Droplets and Hunyuan3D, DigitalOcean, 28/10/2025

[4] Mehul Gupta, Hunyuan-3D-2.1 : Generate Photorealistic 3D image, Medium, 19/06/2025

📺Videografia

[0] Foxsource, Il modo più semplice per Generare Modelli 3D (Text to 3D Generator con Meshy AI), Youtube

[1] , From 2D Generative AI 🍌 Nano-banana to Exquisite 3D Prints: Turning Concepts into Detailed Reality, Youtube

[2] KSPMN | Tutoriales sobre IA y efectos visuales , 🖼️ Transforma Imágenes en 3D con IA: Tutorial Completo de Meshy AI (Fácil y Rápido) 🤖, Youtube

[3] Fox Bandit, 2D Photo to 3D Animation-Ready Model Tutorial | Gemini's Nano Banana + Rodin AI + Blender, Youtube

[4] GOVAJU 3D Printing, Le pasé 2 fotos a una IA y salió ESTA LOCURA | Hitem 3D, Youtube

[5] GOVAJU 3D Printing, IDEA → 3D REAL en 5 min 💥 | Probé Meshy 5: ¿hype o herramienta?, Youtube

[6] Help 3D , #14 - LIVE con Salvatore Sanfilippo "antirez" - Stampa 3D e Intelligenza Artificiale, Youtube

[7] Día de la Toalla, Esta I.A nos dejó sin Laburo? | Cómo pasar de 2D a 3D con un solo click - Guía Paso a Paso, Youtube

[8] Ulises Alvarado 3d, Crea Modelos 3D GRATIS con AI: Pinokio + Hunyuan 3D + Blender, Youtube

[9] Tech-Practice, Hunyuan3D-2: text or image to 3D model running locally (step by step guide), Youtube

[10] A3D prints, Hunyuan IA: Convierte Texto o imagenes en Modelos 3D GRATIS en segundos 😱 Curso IA generativa, Youtube

[11] askNK, Microsoft Free & OpenSource 3D Model & Asset Creator Is Here! (v2), Youtube

[12] Stefan 3D AI Lab, Create 3D with AI for FREE - Full Workflow, Youtube

🔎Papers

[0] Zhihao Li, Sparc3D: Sparse Representation and Construction for High-Resolution 3D Shapes Modeling, Arxiv, 20/05/2025