AI Tinkerers: mi primer meetup en Medellín

Participé por primera vez en un meetup del grupo AI Tinkerers, realizado en los espacios de Nodo en la Universidad EAFIT de Medellín. Nodo es el centro de formación y experimentación tecnológica de la universidad, creado para desarrollar habilidades prácticas en IA, ciencia de datos y desarrollo de software, gracias a alianzas con empresas e instituciones públicas. Es un entorno enfocado en resolver problemas concretos, promoviendo el encuentro entre la comunidad de profesionales y la investigación académica, con un enfoque orientado a resultados.

Nodo, inaugurado en julio de 2022, propone hackatones, talleres y rutas formativas breves, actualizables cada mes y libres de la rigidez académica tradicional. Entre las iniciativas que alberga destacan también los eventos de la dinámica comunidad AI Tinkerers, constituida formalmente en abril de 2024 con el “Lanzamiento de AI Tinkerers Medellín”, que ya ha comenzado a reunirse con regularidad para explorar y experimentar colectivamente con tecnologías de IA (“AI Tinkerers: una nueva ola de makers en Medellín”, 2024).

Una tarde entre campus e innovación

Era la primera vez que participaba en un evento de este tipo y, al llegar con cierto adelanto por la tarde — alrededor de las 16:00 — aproveché para detenerme en el centro comercial Oviedo, cerca de la universidad, donde me permití un palito de queso. Junto con este tentempié estaba leyendo “Geopolítica de la inteligencia artificial” de Alessandro Aresu, un ensayo que analiza cómo la IA está redefiniendo los equilibrios políticos, económicos y estratégicos globales, con especial atención a los desafíos de la gobernanza y al papel de las grandes potencias.

Después de esta pausa, antes de encontrar la sede del evento en el Bloque 18 (Piso 2), di una vuelta por el campus universitario, aprovechando el tiempo disponible para explorar los espacios y respirar la atmósfera académica. El inicio oficial del encuentro estaba previsto para las 18:00.

Talk Time: ideas y aprendizajes del meetup

El programa incluía tres charlas, pero solo dos eran las que más me interesaban por su afinidad con mi trabajo. Al inicio se presentaron algunos problemas técnicos: la pantalla no funcionaba correctamente, obligando a ponentes y asistentes a esperar unos minutos para resolver la conexión de video. Una vez solucionado el inconveniente, las charlas pudieron comenzar con normalidad.

La primera charla se centró en la construcción de sistemas meta-agénticos, es decir, arquitecturas en las que un “meta-agente” es capaz de generar el prompt para coordinar y supervisar a otros agentes más pequeños. Finalmente, mediante simulaciones y métricas de evaluación como Ragas, estos sistemas permiten probar el desempeño de los agentes en escenarios realistas, reduciendo la probabilidad de generar alucinaciones y aumentando la robustez general de las respuestas.

La segunda charla presentó, en cambio, una arquitectura agéntica aplicada a redes Wi-Fi. Partiendo de un Small Language Model (sLM) como Mistral 7B, se construyó un agente especializado en ofrecer respuestas técnicas confiables, con baja latencia y sin depender de modelos de gran tamaño en la nube.

Esta solución aprovecha la llamada agent distillation, es decir, la transferencia de conocimiento desde un large language model (LLM) como Gemini 2.5 hacia un modelo más pequeño y liviano (sLM), optimizado para operar on-premise. Además, se adoptó un enfoque de razonamiento paso a paso (Chain of Thought), validado tanto por expertos humanos del dominio como por herramientas automáticas como RagaAI.

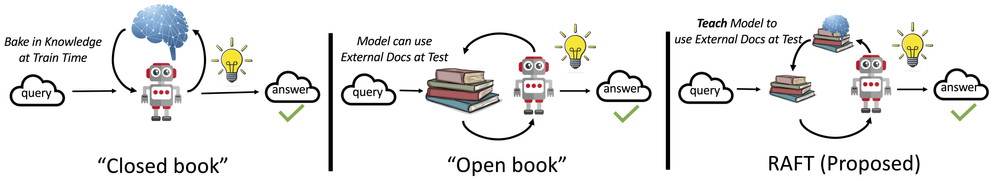

Una parte particularmente interesante de esta presentación fue la explicación de RAFT (Retrieval-Augmented Fine-Tuning), una técnica que integra directamente la fase de recuperación de información (retrieval) dentro del proceso de entrenamiento del modelo.

A diferencia del enfoque clásico de RAG, donde retrieval y generation permanecen separados, RAFT unifica ambas fases en un único proceso, simplificando la pipeline y haciendo las respuestas más estables y consistentes. Este enfoque entrena al modelo no solo para usar documentos relevantes, sino también para ignorar aquellos que no lo son, reduciendo errores derivados de embeddings deficientes o de un chunking poco preciso.

Además, RAFT introduce marcadores específicos (por ejemplo, ##begin_quote## y ##end_quote##) para señalar de manera transparente los fragmentos copiados de los documentos, ayudando al modelo a citar con precisión las fuentes y a disminuir aún más las alucinaciones. En la práctica, es como preparar a un LLM para un “examen a libro abierto”, pero limitado a un dominio específico, para aprovechar al máximo las fuentes pertinentes.

Durante la charla se mostró el flujo completo de trabajo: desde el entrenamiento inicial, hasta el despliegue en vLLM, pasando por la integración vía API y casos reales de preguntas técnicas gestionadas por el agente. Precisamente vLLM, gracias a su gestión eficiente de la memoria y al paralelismo, permitió reducir drásticamente los tiempos de latencia y los costos, mejorando la escalabilidad en escenarios productivos.

What I took away

Este primer meetup de AI Tinkerers en Nodo EAFIT me dejó la certeza de que la comunidad de IA, también aquí en Medellín, está enfrentando desafíos muy similares a los que he visto en Europa: llevar los modelos a producción, garantizar coherencia y reducir costos.

Me resultó especialmente estimulante ver cómo enfoques como los meta-agentes, la destilación agéntica y técnicas como RAFT pueden mejorar la estabilidad y confiabilidad de los modelos, acercándolos a las necesidades reales de las empresas.

Sitografia

[0] Primer año de Nodo, un centro con conexión ganadora para los graduados de la U, 15/04/2025

Papers

[0] Cedric Vidal, RAFT: A new way to teach LLMs to be better at RAG, Microsoft Tech Blog, 15/03/2024

[1] Tianjun Zhang, et al., RAFT: Adapting Language Model to Domain Specific RAG, 05/06/2024

[2] Minki Kang, et al., Distilling LLM Agent into Small Models with Retrieval and Code Tools, 23/05/2025